Navegar na Internet, para alguns, pode ser apenas acessar páginas virtuais sem ter a mínima influência sobre o conteúdo que se é acessado funcionando da seguinte forma: o usuário acessa uma página e lê o seu conteúdo ou baixa algum arquivo; a interação nesse caso é mínima. O ponto mais interativo, talvez, nesse modelo é o preenchimento de formulários, a participação em fóruns de discussão, o expressar de opiniões a respeito de uma notícia ou postagem ou o envio de dados por meio de alguns sites. Acontece que a Internet não é só isso ao ponto de se dizer que ela evolui para um novo modelo cunhado como Web 2.0.

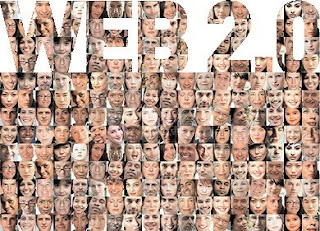

A Web 2.0 é o nome utilizado para se referir à “nova” forma como as pessoas interagem com a Internet. Nessa rede o ponto forte é que são os próprios internautas que colaboram para a criação de conteúdos virtuais e para o avanço da rede mundial. Notadamente, nesse ambiente têm-se os seguintes exemplos: comunidades de relacionamento como o Orkut, comunidades de conteúdo como a Wikipédia, comunidades de informação como blogs e podcasts, comunidades de entretenimento como o YouTube, forma de compartilhamento de informações onde os usuários transformam as suas máquinas em servidores de arquivos torrent, comunidades de comercialização entre usuário como o Mercado Livre, entre outros.

O sucesso desses mecanismos tão utilizados por muitas pessoas é possibilitado pelos usuários que fazem o crescimento desses serviços serem tão promissores e tão divulgados, além de produzirem o conteúdo acessado. O papel das empresas que disponibilizam essas aplicações é fazer com que essas estejam funcionando perfeitamente e que a melhoria contínua do serviço, implícita ou explicitamente sugerida pelos usuários, seja implementada a partir de uma atitude visionária na busca da melhor forma de agradar ao público-alvo.

Outro fator é que a Internet torna-se nesse paradigma uma grande plataforma por abrigar as aplicações que nela são executadas. A dependência do uso de softwares aplicativos e o pagamento de licença de uso “cai por terra” num modelo onde o que importa é a disponibilidade e a gratuidade das aplicações visto que os usuários tornam-se “sócios” das empresas dona da aplicação ao contribuírem com o sucesso do serviço e as organizações precisam do usuário para que o serviço tenha sucesso. Logicamente que a empresas mantenedoras das aplicações ganham quando os seus produtos ficam em destaque na Internet e o usuário “ganha” com a existência da aplicação.

Na Web 2.0 o que importa é o espírito colaborativo e interativo dos usuários. No Mercado Livre, por exemplo, para saber se um vendedor é confiável o comprador vê a positividade do vendedor e os depoimentos que são definidos por quem já comprou produtos daquele fornecedor. Dúvidas podem ser sanadas lendo-se o histórico de perguntas dirimidas ao vendedor ou fazendo-se novos questionamentos. O ganho do site fica por conta dos anúncios nele afixados e por conta do recebimento de pequenas taxas das transações realizadas pelos usuários.

Os blogs também, como produtos da Web 2.0, são grandes oportunidades para que as pessoas possam ir além do conteúdo das mídias tradicionais (jornais, revistas, TV, rádio, etc.). A vantagem é que profissionais podem levar o seu ponto de vista diretamente ao seu público fazendo com que informações profissionais não sejam distorcidas por jornalistas, ou falsos jornalistas leigos ao assunto, tornando o conteúdo publicado algo mais técnico e profissional do que meramente informativo ou descritivo. Um Professor de Medicina, por exemplo, poderia criar um canal de comunicação direto para os seus alunos onde poderia explicitar o conteúdo abordado em sala de aula e, ao mesmo tempo, poderia estar contribuindo com os outros milhões de alunos ou profissionais que se interessassem por aquele assunto. A desvantagem dos blogs seria a desinformação gerada por quem não possui conhecimento levando uma falsa informação aos seus leitores. Um mecanismo regulador são as opiniões dos leitores que deixam o seu parecer a respeito das postagens ou notícias influenciando assim, negativa ou positivamente, na confiabilidade daquela informação.

Outro mecanismo interessante na rede 2.0 são os agregadores de feeds. Essa tecnologia faz com que, ao invés do usuário ir até a informação, a informação vá até ele de uma forma mais organizada, precisa e mais fácil de ser gerenciada. Outros modelos complementam a Web 2.0 como o e-commerce (já comentado no exemplo do Mercado Livre), widgets, aplicativos open-social, etc.

A Web é um “mar” de possibilidades e os horizontes continuam a se ampliar. Nos dias atuais “navegar é preciso” nas fontes de conhecimento virtualmente disponível. Importa termos uma boa bússola para nos orientar nessa empreitada.

Rozenildo Rodrigues Pedroso

Bacharelando em Sistemas de Informação